ในทศวรรษที่ผ่านมา โลกของ AI ได้เกิดการเปลี่ยนแปลงครั้งใหญ่ เหมือนกับมีสติปัญญาประเภทใหม่ที่แปลกประหลาดปรากฏขึ้นบนโลกใบนี้ เป็นปัญญาที่มีความสามารถยอดเยี่ยม แต่ก็ยังมีข้อผิดพลาดที่ร้ายแรงซึ่งมนุษย์ไม่เคยทำ และยังไม่สามารถทำการวิเคราะห์เชิงลึกแบบที่มนุษย์ทำได้อย่างเต็มที่ ความสามารถและจุดอ่อนของ AI นี้ยังคงลึกลับ และเรายังเข้าใจมันน้อยมาก

วิวัฒนาการของสติปัญญามนุษย์และ AI

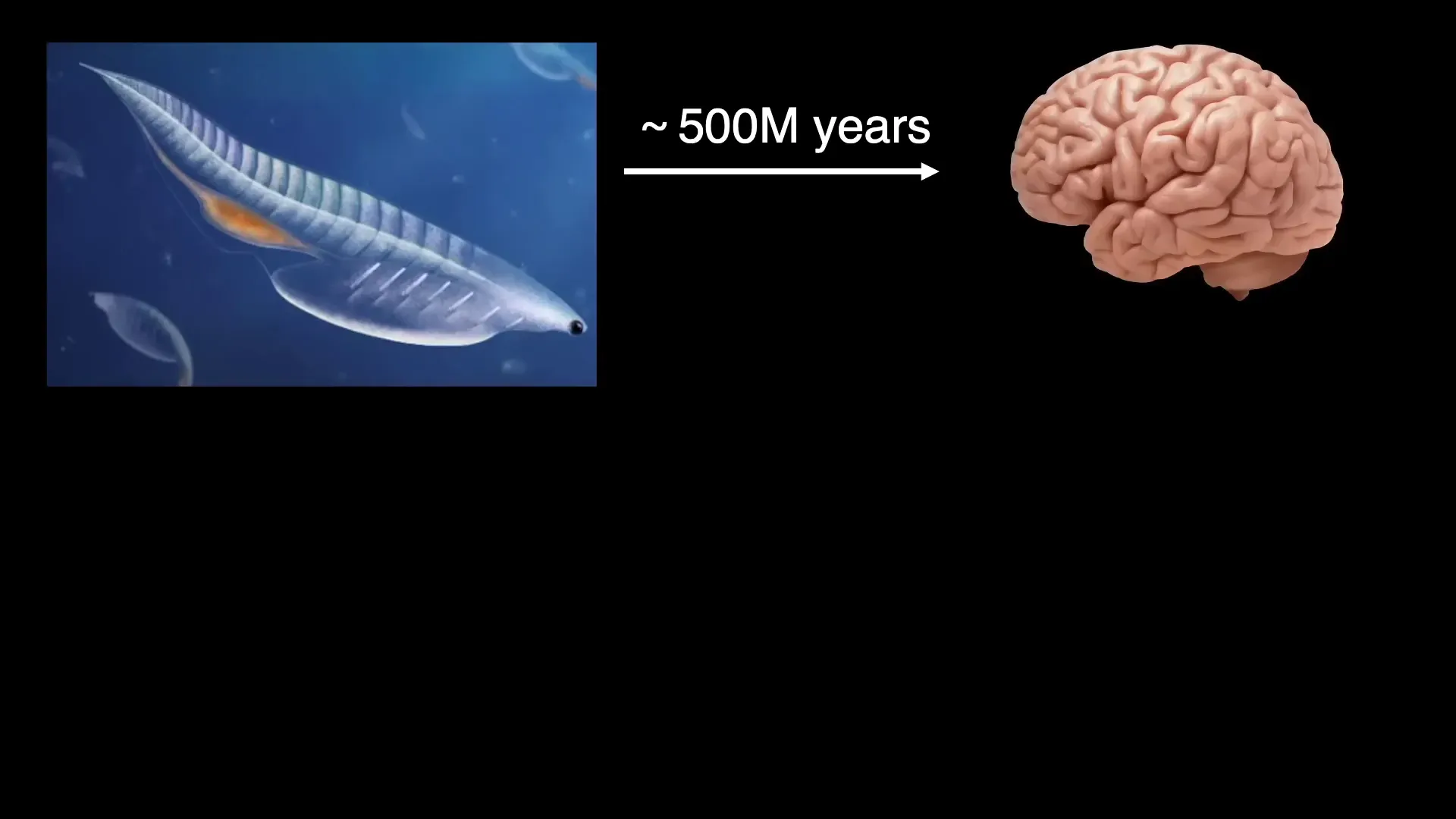

เพื่อเข้าใจ AI อย่างลึกซึ้ง จำเป็นต้องมองย้อนกลับไปยังบริบททางประวัติศาสตร์ของสติปัญญาชีวภาพ เริ่มจากบรรพบุรุษร่วมของสัตว์มีกระดูกสันหลังทั้งหมด ที่มีอายุราว 500 ล้านปี จากสิ่งมีชีวิตตัวเล็กๆ ตัวนี้ วิวัฒนาการได้สร้างสมองที่ซับซ้อนขึ้น จนมนุษย์สามารถคิดค้นคณิตศาสตร์และฟิสิกส์ลึกซึ้งเพื่อเข้าใจจักรวาลตั้งแต่ควาร์กจนถึงจักรวาลวิทยาได้ในเวลาไม่กี่ร้อยปี โดยไม่ต้องพึ่งพา AI อย่าง 聊天GPT

การพัฒนาของ AI ในทศวรรษที่ผ่านมาเป็นเรื่องน่าทึ่ง แต่เพื่อทำความเข้าใจอย่างแท้จริง เราต้องผสมผสานความรู้จากฟิสิกส์ คณิตศาสตร์ ประสาทวิทยา จิตวิทยา และวิทยาการคอมพิวเตอร์ เพื่อสร้างศาสตร์ใหม่ที่เรียกว่า "Science of Intelligence" ที่จะช่วยให้เราเข้าใจทั้งสติปัญญาชีวภาพและสร้าง AI ที่ดียิ่งขึ้น

1. การแก้ปัญหาความต้องการข้อมูลจำนวนมาก (Data Efficiency)

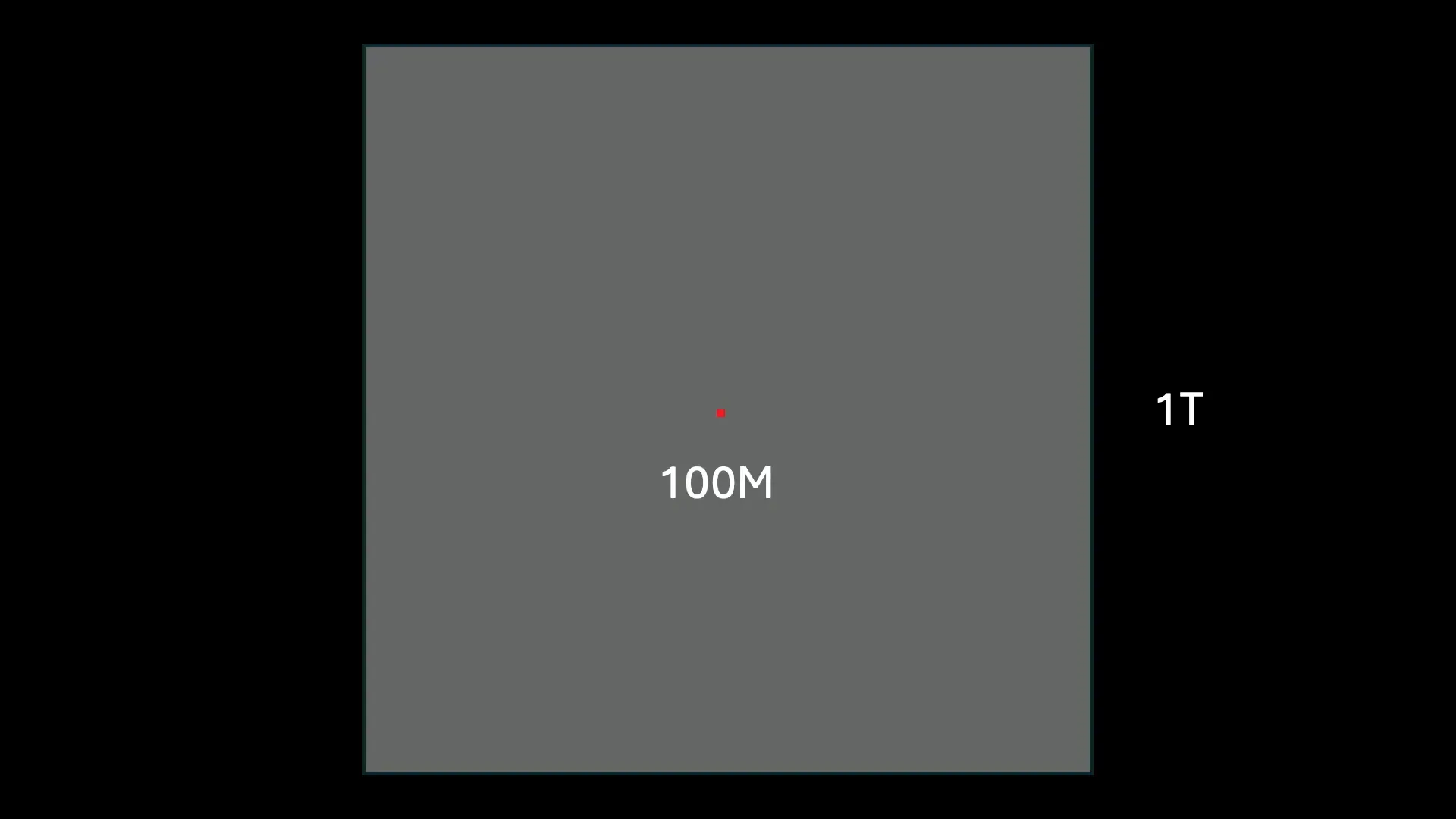

AI ในปัจจุบันต้องการข้อมูลมหาศาลในการเทรน เช่น โมเดลภาษาขนาดใหญ่ต้องเทรนด้วยคำมากถึงหนึ่งล้านล้านคำ ขณะที่มนุษย์ได้รับข้อมูลจากการเรียนรู้จริงเพียงประมาณ 100 ล้านคำเท่านั้น ซึ่งน้อยกว่ามาก การอ่านข้อมูล AI เทรนต้องใช้เวลาถึง 24,000 ปีในมาตรฐานมนุษย์

แม้จะมีวิวัฒนาการสมองมาตั้งแต่ 500 ล้านปี แต่ข้อมูลที่เราได้รับผ่าน DNA มีขนาดเพียงประมาณ 700 เมกะไบต์ หรือเทียบเท่าประมาณ 600 ล้านคำ นั่นหมายความว่าสติปัญญามนุษย์มีความสามารถเรียนรู้ได้อย่างมีประสิทธิภาพมากเมื่อเทียบกับ AI ที่ต้องการข้อมูลมหาศาล

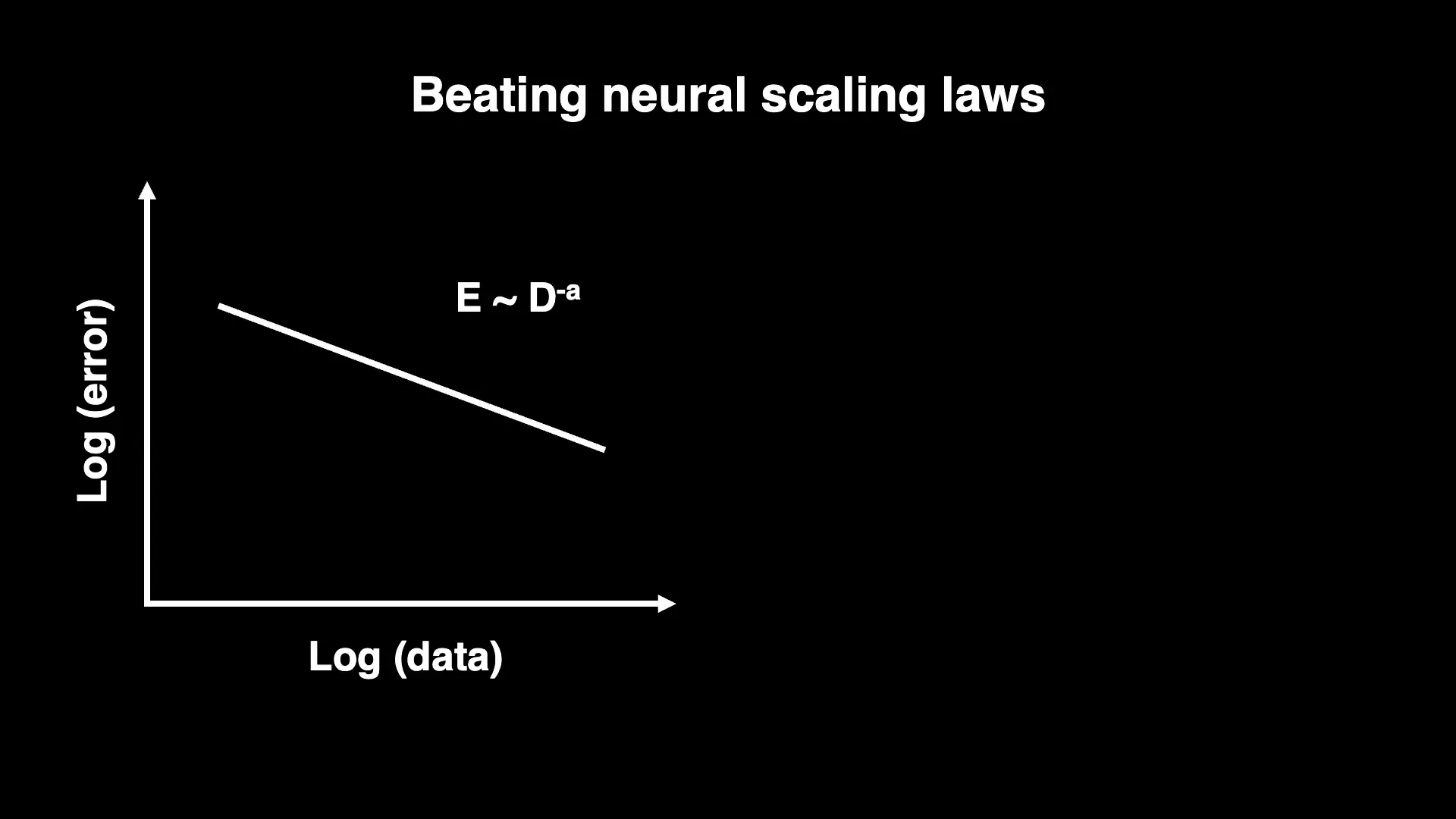

ปัญหาที่เกิดขึ้นอีกประการคือ "Scaling Laws" หรือกฎการเพิ่มขนาดของข้อมูล ซึ่งระบุว่าเมื่อเพิ่มข้อมูลเทรนมากขึ้น ความผิดพลาดของโมเดลจะลดลงในอัตราที่ช้าเกินไป กล่าวคือ ต้องเพิ่มข้อมูลจำนวนสิบเท่าเพื่อให้ความผิดพลาดลดลงเพียงเล็กน้อย ซึ่งไม่ยั่งยืนในระยะยาว

ทีมงานได้พัฒนาทฤษฎีที่อธิบายว่าเพราะเหตุใดข้อมูลจำนวนมากถึงซ้ำซ้อนและไม่ก่อให้เกิดความรู้ใหม่มากนัก ทำให้การเพิ่มข้อมูลไม่คุ้มค่า อย่างไรก็ตาม หากเราสามารถสร้างชุดข้อมูลที่ไม่มีความซ้ำซ้อน โดยเลือกข้อมูลที่มีสาระสำคัญใหม่ๆ อย่างเฉพาะเจาะจง จะช่วยให้การเรียนรู้มีประสิทธิภาพกว่ามาก และสามารถลดความผิดพลาดได้มากขึ้นโดยไม่ต้องเพิ่มข้อมูลมหาศาล

ตัวอย่างเปรียบเทียบการเทรน AI กับการสอนเด็ก

ลองจินตนาการว่าเราสอนเด็กโดยให้เด็กทำนายคำต่อไปในข้อความอินเทอร์เน็ตแบบสุ่มตลอดเวลา นั่นจะทำให้เด็กต้องใช้เวลาถึง 24,000 ปีในการเรียนรู้สิ่งที่มีประโยชน์ แต่ในความเป็นจริง เราสอนเด็กแบบต่างออกไป เช่น การสอนคณิตศาสตร์ เราสอนวิธีแก้โจทย์โดยใช้ขั้นตอน (algorithm) เด็กจึงสามารถแก้โจทย์ใหม่ๆ ได้ด้วยข้อมูลที่น้อยกว่ามาก นี่คือแนวทางที่ AI ควรจะพัฒนาไป — จากการเรียนรู้แบบสุ่มเป็นการสอนที่มีประสิทธิภาพ หรือที่เรียกว่า "Machine Teaching"

2. การเพิ่มประสิทธิภาพพลังงาน (Energy Efficiency)

สมองของมนุษย์ใช้พลังงานเพียง 20 วัตต์ เทียบกับหลอดไฟเก่าที่ใช้ 100 วัตต์เท่านั้น แต่ AI ในการเทรนโมเดลขนาดใหญ่บางครั้งต้องใช้พลังงานถึง 10 ล้านวัตต์ หรือแม้กระทั่งมีการพูดถึงการใช้พลังงานนิวเคลียร์สำหรับศูนย์ข้อมูลขนาดหนึ่งพันล้านวัตต์

สาเหตุที่ AI ใช้พลังงานมากกว่าสมองมนุษย์มากมาจากการใช้คอมพิวเตอร์ดิจิทัลที่ต้องการการเปลี่ยนสถานะบิต (bit flip) อย่างรวดเร็วและแม่นยำ ซึ่งตามหลักเทอร์โมไดนามิกส์ การเปลี่ยนสถานะที่รวดเร็วและแม่นยำต้องใช้พลังงานสูง ในขณะที่สมองทำงานแตกต่างออกไป โดยใช้การคำนวณที่ช้าและไม่แม่นยำในแต่ละขั้นตอน แต่คำนวณให้ถูกต้องในเวลาที่เหมาะสมเท่านั้น

นอกจากนี้ สมองยังใช้หลักการที่เข้ากับฟิสิกส์โดยตรง เช่น การบวกในสมองเกิดจากการรวมแรงดันไฟฟ้าของเซลล์ประสาท ซึ่งตรงกับกฎแมกซ์เวลล์ของแม่เหล็กไฟฟ้า ในขณะที่คอมพิวเตอร์ใช้วงจรทรานซิสเตอร์ที่ซับซ้อนและใช้พลังงานมากกว่า

ดังนั้น การสร้าง AI ที่ประหยัดพลังงานจึงต้องเริ่มจากการออกแบบเทคโนโลยีตั้งแต่ระดับอิเล็กตรอนจนถึงอัลกอริทึมใหม่ ที่เข้ากับหลักฟิสิกส์และไดนามิกส์ของระบบมากขึ้น

ตัวอย่างที่น่าสนใจคือ การคำนวณการรับรู้ (sensing) ซึ่งเป็นหน้าที่ของเซลล์ประสาท เราสามารถคำนวณขีดจำกัดพื้นฐานของความแม่นยำของการรับรู้โดยใช้พลังงานเท่าไร และพบว่าเซลล์ประสาทใช้โมเลกุลที่คล้ายกับ G-protein coupled receptors ซึ่งทำงานใกล้เคียงกับขีดจำกัดนี้ แสดงว่าชีววิทยาสามารถเข้าถึงประสิทธิภาพสูงสุดตามข้อจำกัดของฟิสิกส์ได้

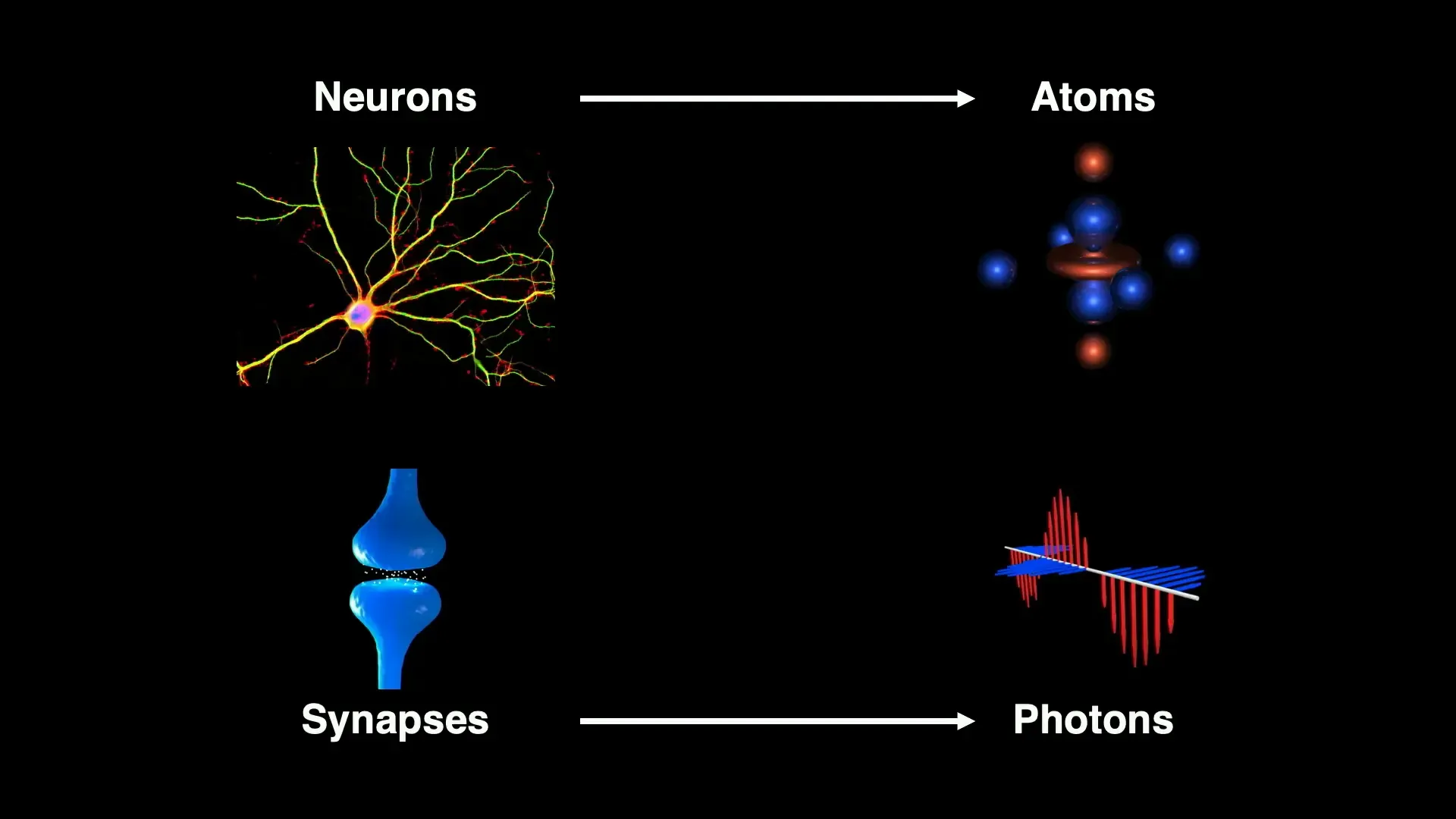

3. การก้าวข้ามวิวัฒนาการด้วย Quantum Neuromorphic Computing

แม้ว่า AI จะเรียนรู้จากสมองและวิวัฒนาการ แต่เราสามารถก้าวข้ามขีดจำกัดของวิวัฒนาการด้วยการนำอัลกอริทึมของสมองมาผสมผสานกับฮาร์ดแวร์ควอนตัม เช่น ใช้สถานะอิเล็กทรอนิกส์ของอะตอมแทนการยิงสัญญาณของเซลล์ประสาท และใช้โฟตอนแทนซินแนปส์

การสร้างหน่วยความจำแบบ associative memory ด้วยอะตอมและโฟตอนนี้สามารถเพิ่มความจุ ความทนทาน และความแม่นยำของการเรียกคืนข้อมูลได้ดียิ่งขึ้น และสามารถสร้าง quantum optimizers ที่แก้ปัญหา optimization ในรูปแบบใหม่โดยตรงด้วยโฟตอน

การผสมผสานนี้ก่อให้เกิดสาขาใหม่ที่เรียกว่า Quantum Neuromorphic Computing ซึ่งถือเป็นก้าวใหม่ของ AI ในอนาคต

4. Explainable AI และการทำความเข้าใจสมอง

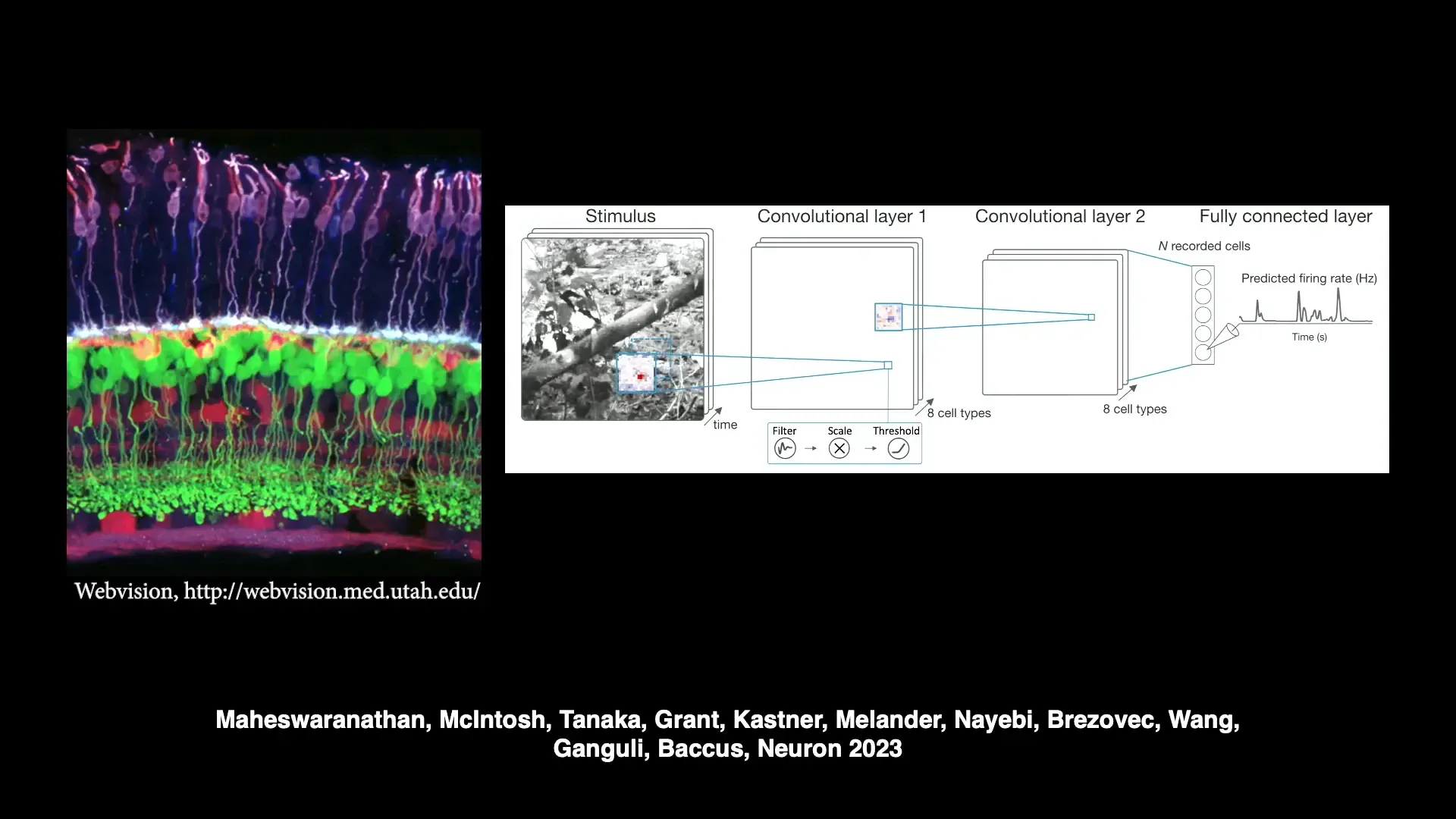

AI ช่วยให้สามารถสร้างโมเดลสมองที่ซับซ้อนและแม่นยำสูง เช่น โมเดลของเรติน่าที่สามารถจำลองผลการทดลองในระยะเวลากว่าสองทศวรรษได้อย่างแม่นยำ ทำให้เราได้ "Digital Twin" หรือแบบจำลองดิจิทัลของเรติน่า

แต่คำถามที่สำคัญคือ โมเดลนี้ทำงานอย่างไร? ตัวอย่างเช่น ในการทดลองง่ายๆ ให้ติดตามการเคลื่อนไหวของมือที่เปลี่ยนทิศทางอย่างผิดธรรมชาติ ซึ่งเป็นการละเมิดกฎฟิสิกส์พื้นฐาน Newton’s First Law ของการเคลื่อนที่ โมเดลสามารถจำลองการตอบสนองของเซลล์ประสาทในเรติน่าที่ตอบสนองต่อการละเมิดนี้ได้อย่างถูกต้อง

เราพัฒนาเทคนิค Explainable AI เพื่อสกัดวงจรย่อยของโมเดลที่รับผิดชอบต่อพฤติกรรมนี้ และอธิบายกลไกการทำงานของมันได้ นี่เป็นก้าวสำคัญที่ช่วยเร่งการค้นพบทางประสาทวิทยาโดยใช้ AI

5. การเชื่อมต่อสมองกับเครื่องจักร (Melding Minds and Machines)

ด้วย Digital Twins ของสมอง เราสามารถสร้างการสื่อสารสองทางระหว่างสมองและเครื่องจักรได้ โดยการบันทึกกิจกรรมประสาทและสร้างแบบจำลอง จากนั้นใช้ทฤษฎีการควบคุม (Control Theory) เพื่อเรียนรู้รูปแบบกิจกรรมที่สามารถควบคุมแบบจำลอง และนำรูปแบบเดียวกันนี้ไปเขียนกลับเข้าสมองจริง เพื่อควบคุมสมองโดยตรง

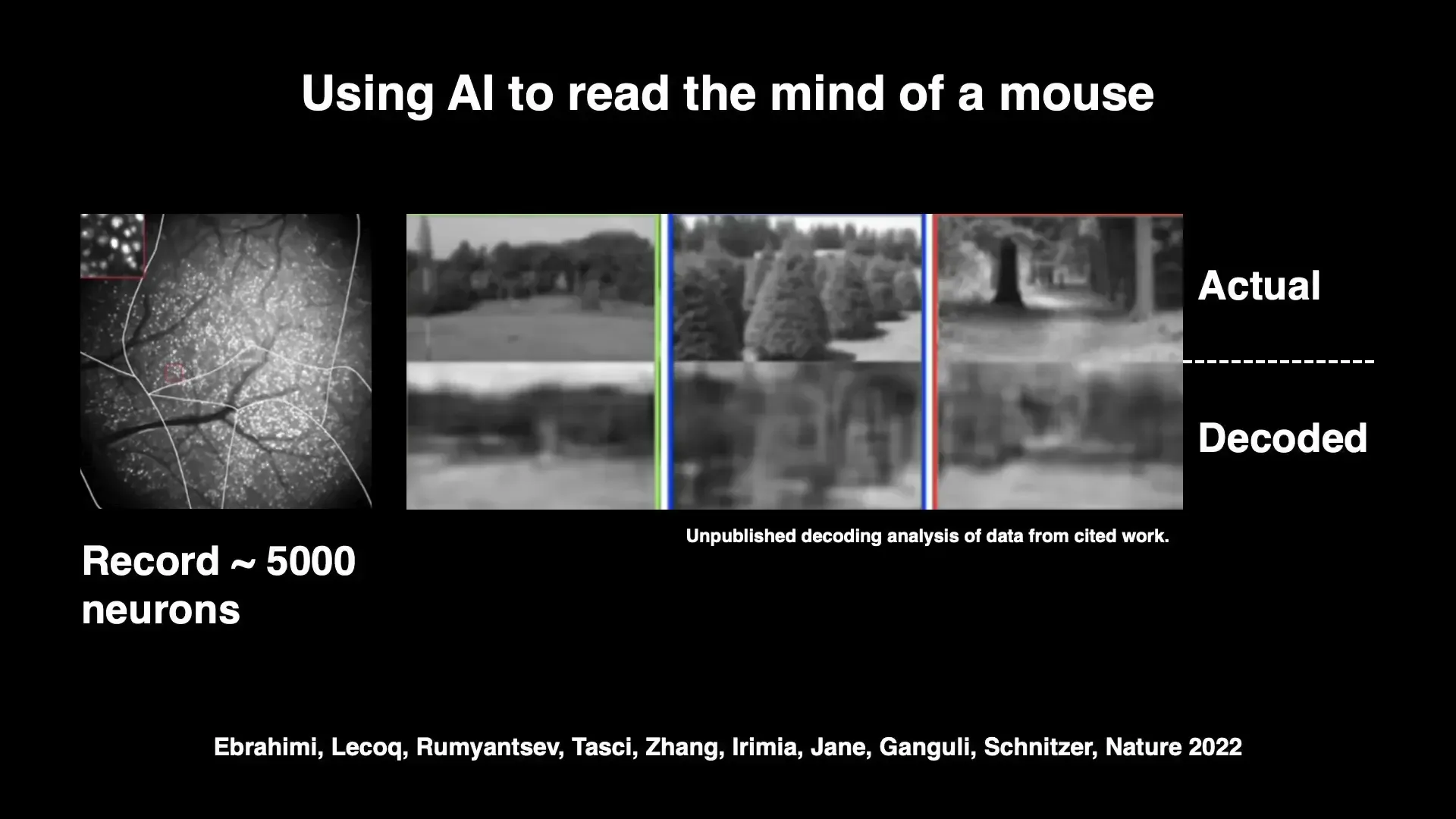

ตัวอย่างที่น่าสนใจคือ การทดลองกับหนูที่สามารถถอดรหัสภาพที่หนูเห็นจากกิจกรรมสมอง และสามารถเขียนกิจกรรมประสาทเพื่อทำให้หนูเห็นภาพที่เรากำหนดโดยควบคุมเพียง 20 เซลล์ประสาทเท่านั้น

นี่เปิดประตูสู่ความเป็นไปได้ในการเข้าใจ รักษา และเสริมสมรรถภาพสมองมนุษย์ในอนาคตอย่างไม่จำกัด

来自 Insiderly 的结论

การพัฒนา AI ในทศวรรษที่ผ่านมาแสดงให้เห็นถึงการเกิดขึ้นของสติปัญญารูปแบบใหม่ที่ยังคงมีความลึกลับและจุดอ่อนมากมาย การเข้าใจและพัฒนาปัญญาประดิษฐ์ที่มีประสิทธิภาพและเข้าใจได้ จำเป็นต้องอาศัยศาสตร์ใหม่ที่ผสมผสานความรู้จากหลายสาขา ทั้งฟิสิกส์ ประสาทวิทยา และจิตวิทยา

การแก้ไขปัญหาความต้องการข้อมูลมหาศาลและพลังงานสูงของ AI จะนำไปสู่การสร้างเทคโนโลยีที่มีประสิทธิภาพและยั่งยืนมากขึ้น เช่น การสร้างชุดข้อมูลที่ไม่มีความซ้ำซ้อน การออกแบบระบบที่เข้ากับฟิสิกส์ธรรมชาติ และการนำควอนตัมคอมพิวติ้งมาผสมผสานกับอัลกอริทึมของสมอง

另外 Explainable AI จะช่วยให้เราเข้าใจสมองมนุษย์ได้ดีขึ้น และการสร้างการสื่อสารสองทางระหว่างสมองและเครื่องจักรจะเป็นกุญแจสำคัญในการพัฒนาการแพทย์และเทคโนโลยีในอนาคต

ความท้าทายและโอกาสเหล่านี้ต้องการการทำงานอย่างเปิดเผยและระยะยาวในวงการวิชาการ ซึ่งจะช่วยให้โลกได้ประโยชน์จากความรู้และนวัตกรรมที่แท้จริงในด้านปัญญาประดิษฐ์และสติปัญญา

คำศัพท์เทคนิค (Jargon)

- Scaling Laws: กฎทางคณิตศาสตร์ที่บอกว่าความผิดพลาดของโมเดลลดลงอย่างไรเมื่อเพิ่มปริมาณข้อมูลเทรน

- Machine Teaching: แนวคิดการสอน AI โดยการเลือกข้อมูลที่มีประโยชน์และเฉพาะเจาะจงแทนการเทรนด้วยข้อมูลสุ่มจำนวนมาก

- Quantum Neuromorphic Computing: การผสมผสานระหว่างอัลกอริทึมทางประสาทวิทยากับฮาร์ดแวร์ควอนตัมเพื่อสร้างระบบคอมพิวเตอร์ที่มีประสิทธิภาพสูง

- Digital Twin: แบบจำลองดิจิทัลของระบบจริง เช่น สมองหรือเรติน่า ที่ใช้สำหรับการศึกษาและการทดลอง

- Control Theory: ทฤษฎีทางคณิตศาสตร์ที่ใช้ในการควบคุมพฤติกรรมของระบบโดยการปรับค่าป้อนกลับ